جثة متفحمة لرضيع إسرائيلي صنعها “الذكاء الاصطناعي”.. عندما تشوش أدوات التحقق من الصور المفبركة على النقاش العام

في 12 تشرين الأول/ أكتوبر الجاري، نشر الحساب الرسمي لإسرائيل صورة لجثة متفحمة مؤكدين أنها تعود لطفل قتلته حركة “حماس” خلال الهجوم المباغت الذي شنته على الدولة العبرية في 7 تشرين الأول/ أكتوبر. وبعد ساعات من نشر الصورة، أكد عدد كبير من مستخدمي الإنترنت أن الصورة تم توليدها بالاعتماد على أدوات الذكاء الاصطناعي وهو ما تؤكده وسيلة التحقق “إي أي أور نوت AI or Not”. لكن عدة خبراء والشركة المطورة للأداة شككوا في هذه النتيجة.

عملية التحقق في سطور

أكد أصحاب حسابات من الولايات المتحدة ومساندون للفلسطينيين على تطبيق إكس (تويتر سابقا) بأن صورة جثة الطفل المتفحمة التي نشرتها دولة إسرائيل تم توليدها عبر وسائل الذكاء الاصطناعي، معتمدين في ذلك على أداة التحقق أي إي أور نوت AI or Not.

ولكن الشركة المنتجة لهذه الأداة أن هذه النتيجة ليست دقيقة. فيما أكد خبراء في تحليل الصور أن الصورة لم يتم توليدها عبر الذكاء الاصطناعي.

كما أكدت عدة تغريدات نشرت صورة الرضيع المتفحم الصورة تم توليدها من صورة جرو. ولكن صورة الكلب كانت بالفعل مفبركة بحسب توضيح خبير في تحليل الصور تواصل معه فريق تحرير مراقبون فرانس24.

عملية التحقق بالتفصيل

يتواصل الصراع على الصورة بشأن ضحايا الهجوم المباغت الذي شنته حركة حماس على إسرائيل في 7 تشرين الأول/ أكتوبر الجاري. ففي 12 تشرين الأول/ أكتوبر، نشر رئيس الوزراء الإسرائيلي بنيامين نتانياهو صورا لجثث أطفال محترقة وضعت في أكياس موتى، على حسابه في تطبيق إكس (تويتر سابقا) مؤكدا أن هذه الصورة تتعلق “بأطفال رضع قتلهم وأحرقهم وحوش حماس” كما تم تداول هذه الصور على الحساب الرسمي لدولة إسرائيل على منصة إكس بعد بضع ساعات من ذلك.

ولكن عددا كبيرا من مستخدمي الإنترنت الأمريكيين ومن مساندي القضية الفلسطينية اتهموا الدولة العبرية بتوليد إحدى هذه الصور بالاعتماد على تقنيات الذكاء الاصطناعي.

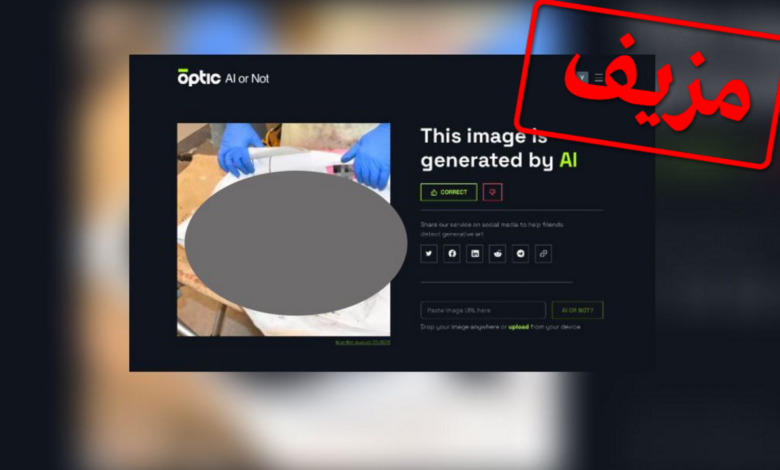

ونددت عدة تغريدات على منصة إكس بينها واحدة حصدت أكثر من 22 مليون مشاهدة بعملية “فبركة للصور” تقف وراء دولة إسرائيل وذلك بالاعتماد على نتائج أداة للتحقق من المولدة بالاعتماد على الذكاء الاصطناعي “أي أور نوت “AI or Not”. ومن خلال نشر صورة مثبتة من الشاشة، أكد عدد من مستخدمي الإنترنت بأن أداة التحقق هذه أكدت أن الصورة “مولدة بالاعتماد على الذكاء الاصطناعي”.

كما تم تداول هذه المعلومة أيضا عبر حساب قناة الجزيرة القطرية على منصة إكس. وفي 14 تشرين الأول/ أكتوبر الجاري، نشرت القناة القطرية مقطع فيديو عن هذا الموضوع حصد أكثر من 500 ألف مشاهدة تقول فيه: “هذه الصورة تعكس حسب إسرائيل “وحشية حماس”… وقد فند الذكاء الاصطناعي مزاعم إسرائيل ضد أعضاء كتائب عز الدين القسام (الذراع المسلح لحركة حماس”.

في نفس هذه الرسائل، وجهت الاتهامات لإسرائيل بتوليد هذه الصورة انطلاقا من صورة كلب ذي فرو أبيض وبني فاتح وجدت داخل نفس كيس الموتى الذي وضعت فيه جثة الطفل.

وتم تداول صور هذا الجرو، التي قيل أنه صورته الأصلية متداولة عبر منتدي فور شان 4chan، وهو موقع يلقى رواجا واسعا في أوساط اليمين المتطرف الأمريكي، منذ مساء يوم 12 تشرين الأول/ أكتوبر 2023.

Table of Contents

نتيجة إيجابية غير صحيحة من أداة التحقق “إي أي أور نوت”

في الحقيقة، تؤكد عدة معطيات بأن الصورة التي نشرتها حكومة إسرائيل لم يتم توليدها بالاعتماد على تقنيات الذكاء الاصطناعي.

كما أن الشركة التي طورت أداة “إي أي أور نوت” شككت بنفسها في النتائج التي توصلت إليها الأداة. ففي تغريدة على منصة إكس في 14 تشرين الأول/ أكتوبر الجاري، أوضحت الشركة أن أداتها يمكن أن تعطي نتائج إيجابية غير حقيقة، أي بما يعني أن الأداة أخطأت في القول بأن صورة الرضيع المتفحم تم توليدها بالاعتماد على الذكاء الاصطناعي، خصوصا عندما تكون الصورة ذات جودة سيئة.

وقالت الشركة في بيانها “لقد تأكدنا بالاعتماد على برامجنا أن النتيجة التي توصلت إليها الأداة ليست دقيقة لأن الصورة كانت ذات جودة سيئة ومعدلة وهو ما جعل الأمر ضبابيا بالنسبة إلى الأداة” خصوصا من جهة اليد اليسرى الظاهرة في الصورة.

وتشير هذه الأداة بأن الصورة “يمكن أن تعود لكائن بشري” وفق ما لاحظه فريقه تحرير مراقبون فرانس24 في 16 تشرين الأول/ أكتوبر الجاري.

وفي اختبار من نفس الأداة أجري في شهر أيلول/ سبتمبر 2023، أكد موقع التحقيقات الاستقصائية بيليننغكات Bellingcat أن هامش الخطأ في هذه الأداة “مرتفع جدا” لتقصي الصورة المولدة عبر تقنيات الذكاء الاصطناعي أو الصور المضغوطة ذات الجودة السيئة، مؤكدا أن هذه النتائج “تقلل بشكل كبير من نجاعته فيما يتعلق بالبحوث عبر المصادر المفتوحة”.

“لا شيء يثبت أن الصورة التي قدمتها حكومة إسرائيل مفبركة”

لا شيء يشير إلى أن الصورة التي قدمتها حكومة إسرائيل تم توليدها بالاعتماد على تقنيات الذكاء الاصطناعي، وفق توضيح هاني فريد المتخصص في تحليل الصور والأستاذ في جامعة بيركلي Berkeley، في تصريح لوسيلة الإعلام 404.

وقد أشار هذا الخبير في الصورة بالخصوص إلى مناطق الظل الدقيقة والتناسق العام للصورة قائلا “هذا ما يدفعني إلى القول بأن الصورة لم يتم توليدها ولو جزئيا عبر تقنيات الذكاء الاصطناعي”.

ويتقاسم هذا الرأي معه دينيس تيسو، المسؤول عن وحدة “ميديا لاب” التابعة لوكالة الأنباء الفرنسية أ ف ب، ومدير الابتكار في مشروع التحقق من الصورة المولدة عبر الذكاء الاصطناعي “فيرا. إي أي vera.ai”. ويقول تيسو في تصريح لفريق تحرير مراقبون في يوم 16 تشرين الأول/ أكتوبر الجاري “لا شيء يثبت أن الصورة التي قدمتها حكومة إسرائيل مفبركة”.

ويوضح هذا الأخير أن أداة التحقق من الصور المفبركة التي طوره موقع “فيرا إي Vera.ai ” لم تكشف أي فبركة مع التذكير دائما بالحدود المفترضة لإمكانيات هذه الأدوات الرقمية في كشف الصور المولدة عبر الذكاء الاصطناعي.

ويخلص تيسو قائلا: “الخطر الكبير لأدوات التحقق من الصور المولدة عبر الذكاء الاصطناعي هو توصلها إلى نتائج إيجابية غير صحيحة. وإذا ما تم التوصل إلى نتيجة إيجابية غير صحيحة، فإن لم يعد من الممكن وضع ثقة في هذه الأداة.

صور جرو “مفبركة”

إضافة إلى ذلك، لم يتم العثور على أي عدم انسجام بين ما توصلت إليه أداة التحقق من الصور مفتوحة المصدر “إنفيد وي فيرفاي InVID-Weverify التي طورها مخبر “ميديا لاب” التابع لوكالة الأنباء الفرنسية الذي يقترح علينا عدة وسائل تحقق من الصور ترصد عمليات فبركة محتملة، حيث لم ترصد الأداة أية فبركة.

ولكن في المقابل، توضح الأداة التابعة لوكالة لأنباء الفرنسية أنه تم إدخال عدة تحويرات على صورة الجرو. “من المرجح أنه الصورة تعرضت للفبركة بالاستعانة بوسائل توليد الصورة” عبر تقنيات الذكاء الاصطناعي، هذا ما أكدته تينا نيكوخاه، الباحثة في الرياضيات التطبيقية في معهد “إي إنس باريس- ساكلاي ENS Paris-Saclay، وذلك في اتصال مع فريق تحرير مراقبون في 16 تشرين الأول/ أكتوبر الجاري.

وكانت هذه الباحثة وراء ابتكار خوارزميات التحقق من عمليات فبركة محتملة وهي متاحة عبر أداة إينفيد وي فيرفاي InVID-We Verify.وتمكنت أداة التحقق هذه التي أطلق عليها اسم “زيرو”، والتي تم تطويرها لتفادي التوصل إلى نتائج فبركة إيجابية غير صحيحة، من أن “آثارا واضحة في خلفية الصورة لم تظهر على أطراف جسم الكلب” وهو ما تظهره اختلافات في درجة اللون الأخضر الداكن على منطقة جسم الكلب والأخضر الباهت في باقي الصورة (انظروا إلى الصورة المنشورة أدناه).

“بالاعتماد على طبيعة هذه الآثار، من المرجح أن تم تحوير هذه الصورة بالاعتماد على أدوات توليد الصور” على غرار أدوات ميد جورناي Midjourney وستابل ديفيجن Stable Diffusion ، وفق تأكيد الخبيرة تينا نيكوخاه.

وتتطابق هذه الاستنتاجات مع أقوال مستخدم إنترنت عبر منصة إكس يؤكد أنه كان وراء توليد صورة الجرو.

وفي تغريدة على منصة إكس في مساء 12 تشرين الأول/ أكتوبر الجاري، أي بعد بضعة ساعات من نشر الصورة على منتدى “فور شان”، قال هذا المستخدم أنه الأمر تطلب منه “خمس ثوان” لتوليد هذه الصورة انطلاقا من الصورة التي نشرتها دولة إسرائيل.

“ليس من الصعب توليد صورة مزيفة قابلة للتصديق” وفق تأكيد هذه المستخدم في تغريدة على منصة إكس قام بحذفها في وقت لاحق. وفي تغريدة أخرى، يوضح صاحب نفس الحساب أنه استخدام برنامج توليد الصور عبر الذكاء الاصطناعي ستابل ديفيجن Stable Diffusion، وأشار باستمرار إلى صورته المولدة عبر تقنيات الذكاء الاصطناعي في تغريدات أخرى.

صور جثث أطفال متفحمة نشرتها إسرائيل دون توضيح سياقها

وعلى الرغم من أنها حقيقية، فإن الصور التي نشرتها إسرائيل لجثث متفحمة قوبلت بانتقادات بسبب عدم توضيح سياقها.

ففي 10 تشرين الأول/ أكتوبر الجاري، اتهمت قناة إي 24 نيوز الإخبارية الإسرائيلية وحكومة الدولة العبرية حركة حماس – دون تقديم دليل- بقطع رؤوس 40 رضيعا في منطقة كفار عازار.

في 11 تشرين الأول/ أكتوبر الجاري، أكد الرئيس الأمريكي جو بادين أن تم “قطع رؤوس أطفال إسرائيليين”. ولكن في نفس المساء، أكد البيت البيض أن الرئيس الأمريكي تلقى هذه المعلومات من مصالح المخابرات الإسرائيلية وأنه لا يمكن أي أدلة إضافية على صحتها.

وفي اليوم التالي، نشرت الحكومة الإسرائيلية صور لجثث أطفال متفحمة موجهة الاتهامات لـ”أولئك الذين يكذبون هذه الوقائع” بـ”دعام” حيوانات متوحشة مسؤولة عن هذه الأحداث” دون أن تقدم بالرغم من ذلك السياق التي حدثت فيه هذه الوفيات.

مصدر الخبر

للمزيد Facebook